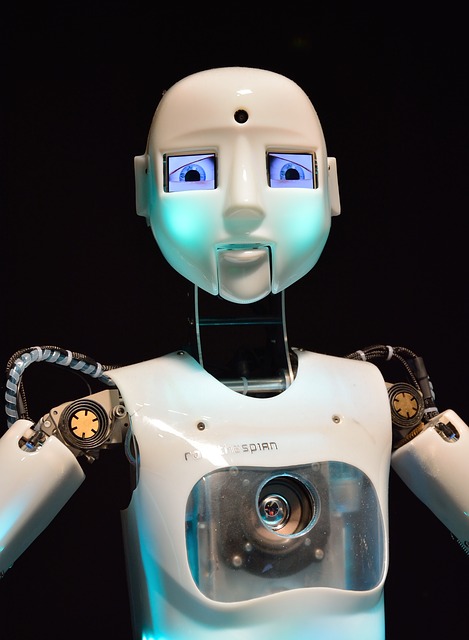

Der Bolerò der Arbeitswelt: Arbeiten 4.0 mit autonomen System

Warum die Digitalisierung hinter der Digitalisierung unsere ganze Aufmerksamkeit benötigt. Von Welf Schröter Wer kennt es nicht, das beeindruckende Orchesterwerk des französischen Komponisten Maurice Ravel. Er schuf im Jahr 1928 jenen langen „Boléro“ als Balettstück, der leise und unmerklich beginnt, sich zunehmend ins Wahrnehmbare steigert und in einem unüberhörbaren Finale gipfelt. Ein solcher „Boléro“ bewegt sich gerade auf die Arbeitswelt zu. Noch sind wir mit den Herausforderungen und Chancen der „nachholenden Digitalisierung“ (Schröter) befasst. Betriebsräte, Vertrauensleute und Beschäftigte betten mit Hilfe kluger Arbeitsorganisationsmodelle vorhandene informationstechnische Werkzeuge in den Arbeitsalltag ein. Mobile Endgeräte, „kluge“ Kleidungsstücke (wearables), „kluge“ Brillen (glasses) und vieles mehr werden über Betriebsvereinbarungen zu Assistenztechniken für den Menschen. Mehr als drei Viertel aller derzeitigen Technikeinführungen nutzen technische Innovationen, die schon zehn oder mehr Jahre auf dem Markt sind. In den Betrieben werden sie als neu empfunden und als neu im Sinne von „4.0-Anwendungen“ dargestellt. Doch unter dem …

Der Bolerò der Arbeitswelt: Arbeiten 4.0 mit autonomen System Weiterlesen »