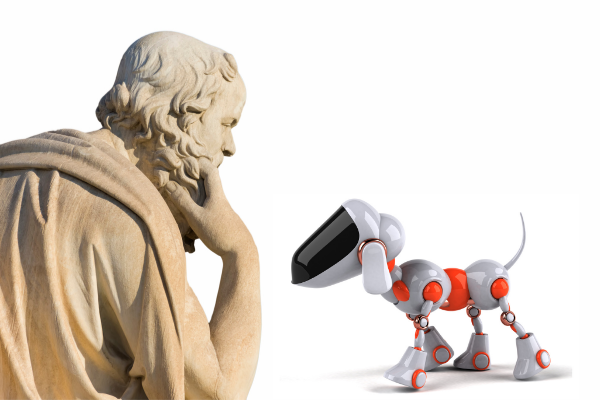

Darf ein Philosoph hetzen?

Fragen Sie sich auch, wohin uns die Entwicklung von Künstlicher Intelligenz (KI) führt? Was bringt sie uns?Wer sich halbwegs ernsthaft damit beschäftigen will, muss auch auf Philosophen hören, die sich mit diesem Thema beschäftigen. Daher hat Michael Mörike, Vorstand der Integrata-Stiftung, den Essay „Künstliche Intelligenz und der Sinn des Lebens“ von Richard David Precht gelesen.Und – um es gleich vorwegzusagen – nun ist er tief enttäuscht.