Vertrauen schaffen in KI

Um „Vertrauen“ in ein System zu haben, ist es notwendig, dass man dessen Entscheidungen nachvollziehen und so verstehen kann. Das ist bei komplexen, monolithischen KI-Systemen oft nicht der Fall. In diesem Beitrag präsentiert unser Blogautor Michael Mörike einen modularen Ansatz, in dem die Entscheidungen der KI prinzipiell nachvollziehbar sind.

Oft wird bemängelt, dass man nicht feststellen kann, warum eine KI wie entschieden hat. Für ein großes neuronales Netz (NN), das aus vielen Schichten besteht, die alle aus vielen Knoten bestehen, ist das aktuell wohl auch richtig. Wer aber sagt, man müsse KI immer aus möglichst nur einem einzigen NN aufbauen?

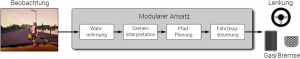

Bei der Konstruktion von KI für autonom fahrende Autos setzt man die eingebaute Intelligenz ja auch aus mehreren getrennten NN zusammen, wie mit dem folgenden Bild erläutert wird.

Im Modul Wahrnehmung wird ein NN eingesetzt, das die Objekte erkennt, also Fußgänger, Verkehrsschilder, Fahrzeuge, Bordstein, etc…. Daraus wird dann ein geometrisches Modell zusammengesetzt, in dem die Objekte räumlich verortet sind, das dann mit Hilfe eines – vom ersten – getrennten NN im Modul Szeneninterpretation analysiert wird: Wie ist die aktuelle Verkehrssituation? Auf dem Ergebnis aufbauend wird die Pfadplanung vorgenommen, wozu klassische Software eingesetzt wird, ebenso wie im Modul Fahrzeugsteuerung, das auf den vorausgehenden Informationen aufbauend, die Aktoren bedient (Bremse, Gas, Hupe, Lenkung, etc…).

Das Bild ist stark vereinfacht. Fortgeschrittene Entweicklungen unterteilen den Informationsfluss zwischen den Sensoren und den Aktoren in wesentlich mehr auf einander aufbauende Module:

- Bilder von Umgebung aufnehmen, Sensoren auslesen – HW

- Objekte erkennen (was gibt es da?) – NN

- Ontologie zuordnen (Wissen über die Objekte zuordnen) – SW

- Umgebung modellieren (Raummodell der Objekte erzeugen) – (NN)

- Kurzfristige Vergangenheit berücksichtigen (Kurzzeitgedächtnis) – SW

- Kurzfristige Zukunft vorhersagen (Vorhersage für nächste Sekunden) – SW

- Eigene Situation analysieren (aktuelle Lage „bewusst machen“) – NN

- Situation anderer Verkehrsteilnehmer analysieren („nachempfinden“?) – NN

- Ziele anpassen / einfügen: – SW

a. Raum- & Zeit- Ziele anpassen (wann wohin?)

b. Ökonomische Ziele anpassen (wofür? was will ich?)

c. Moralische Ziele anpassen (erlaubt? soz. Mehrwert?) - Ziele gegeneinander bewerten (auf Basis aktueller Situation) – NN

- Mögliche nächste Schritte planen (kürzesten/besten Weg suchen) – SW oder NN

- Wichtige Objekte markieren für verbesserte Situationsanalyse – SW

- Nächsten Schritt auswählen (besten Weg) – SW oder NN

- Aktionen ausführen (gemäß ausgewähltem Optimum) – HW

Der Hinweis am Ende der Zeile (in Fettdruck) gibt an, mit welcher Technik die Module jeweils realisiert werden: (HW=Hardware evtl. mit embedded SW, NN=Neuronales Netz; SW=klassische Software)

Die ganze Konstruktion ist hier stark vereinfacht dargestellt. Sie ist auch nicht konsequent nur linear aufgebaut, sondern enthält Rückkopplungsschleifen. Beispiel: wenn ein wichtiges Objekt in der Situationsanalyse erkannt ist, muss es nochmals genauer betrachtet werden. Dann wird die Objektanalyse (2) am Anfang mit anderen Vorgaben wiederholt („genauer hinschauen“).

Was hat das aber mit Vertrauen zu tun?

Ein Modul gibt die Information an das nächste weiter – wie bei einem klassischen Interface. Dort steht die transportierte Information mit klar erkennbarer Bedeutung zur Verfügung. Man könnte sie in einer „black box“ wie beim Flugzeug abspeichern und später – z.B. im Falle eines Unfalls – auslesen, was da abgelaufen ist. Zu Forschungszwecken kann man natürlich auch in weniger bedauerlichen Fällen nachsehen.

Ich meine, dies fördert auf jeden Fall das Vertrauen.

Was lernen wir daraus? Wenn man KI nicht monolithisch aufbaut, sondern in möglichst viele Module unterteilt, kann man die verarbeiteten Informationen wesentlich besser verstehen und damit auch den am Ende stehenden Vorschlag für eine Entscheidung. Rückkopplungsschleifen verbessern dies sogar nochmals.

Geht man noch einen Schritt weiter und fasst die eingesetzten NN nicht als die wichtigsten Teile des Gesamtsystems auf, sondern ähnlich Subroutines in einem großen Softwaresystem, ordnet ihnen gedanklich also beitragende Funktion zu, dann kann man das Gesamtsystem wieder als ein „klassisches“ Informationen verarbeitendes System ansehen und auch so behandeln. Indem man für die NN möglichst kleine Aufgaben vorsieht, werden sie besser beherrschbar. Außerdem wird die Datenbeschaffung und die Konnotierung für das vorgefertigte Lernen einfacher, weil die Anforderungen einfacher sind. Dies sind weitere Vorteile.

Vermutlich kann man solche System dann auch zertifizieren.